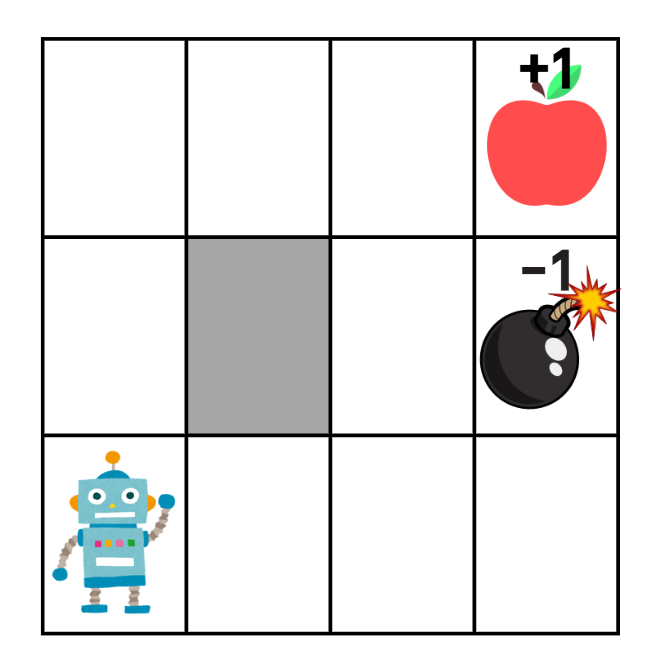

본 글은 강화학습과 신경망에 대한 기초적인 지식(벨만 방정식, Q-Learning, 퍼셉트론, FNN, CNN, RNN, etc.)이 있다고 가정하고 작성되었습니다.또한, 본 글은 DQN/정책 정사법과 관련된 내용을을 다루지는 않으니 주의해주시기 바랍니다.신경망을 위한 전처리신경망에서 '범주형 데이터'를 다룰 때에는 원-핫 벡터로 변화나는 것이 일반적이다.범주형 데이터: 범주로 묶을 수 있는 것. 혈액형이나 옷 사이즈 등원-핫 벡터: 한 개의 원소만 1이고 나머지는 모두 0인 벡터예를 들자면, 혈액형 A/B/AB/O 를 각각 (1,0,0,0)/(0,1,0,0)/(0,0,1,0)/(0,0,0,1)로 치환하는 것이다.그럼 아래와 같은 문제는 어떻게 원-핫 벡터로 바꿀 수 있을까?3x4 크기의 셀을 각각 범주..